数字时代,我们所有人的生活都离不开芯片。我们的电脑、手机,乃至出行的汽车上,都装有大量芯片。只要有一个芯片无法正常工作,都会影响到我们的生活,轻则手机失灵,重则汽车失控……

在享受芯片便利的同时,我们有没有想过芯片为什么对数字时代如此重要?它的开发和制造又为什么这么困难?这还要从芯片的历史说起。

从真空管到晶体管

“上古结绳而治”。自人类文明诞生以来,计算便成了我们生活不可分离的一部分。小到一个家庭的收支平衡,大到一个国家的经济走向,这些决定家庭或是国家命运的数字,无不需要计算才能得出。人们为此开发出了不少计算工具,如上下拨动珠子的算盘,或是可以按下按钮的计算器,来获得想要的结果。

随着我们对计算需求的不断增加,基于人力的计算方式很快就遭遇了瓶颈。战争催生了早期电脑的诞生:图灵依赖电动机械原理开发的计算机,破解了德国的恩尼格玛密码;而为了破解德国的洛伦兹密码,英国又开发了“巨人计算机”(Colossuscomputer),这也被认为是世界上第一台可以编程的数字计算机。这些机器可以轻易完成仅靠人类难以做到,甚至不可能实现的计算。

巨人计算机的运作核心是“真空管”,它们看起来就像是一个硕大的灯泡,里头装有一些金属丝。通上电后,这些金属丝无外乎两种命运:有电,或是没电,这对应了二进制中的1和0。利用这两个数字,理论上可以进行任何计算。我们如今的网络虚拟世界,也可以近似理解为诞生于无数个1和0之上。

基于真空管的计算机功能虽然强大,却也有着自身的多个局限。

一方面,真空管体积太大了。宾夕法尼亚大学制造的ENIAC机有超过1.7万根真空管,占地庞大,耗电量也相当恐怖;另一方面,这些海量数字的真空管,也带来了各种隐患。据统计,平均每2天,这台机器就会发生真空管故障,每次排查至少需要15分钟。为了稳定地产出各种1和0,人们开始寻找真空管的替代品。

知名的贝尔实验室做出了突破,而他们的选择是半导体——这种材料的导电性基于导体(能让电流自由通过,如铜制的电线),以及绝缘体(完全不导电,如玻璃)之间。在特定的条件下,它的导电特性可以发生变化。比如我们都听说过的“硅”(Si),它本身并不导电,但只要加入某些其他材料,就可以具有导电性。“半”导体的名字,正是由此而来。

贝尔实验室的威廉·肖克利(WilliamShockley)先提出了一个理论,认为在半导体材料附近加上电场,可以改变它们的导电性,然而他却无法用实验来证实自己的理论。

受到该理论启发,他的两名同事约翰·巴丁(JohnBardeen)与沃尔特·布拉顿(WalterBrattain)两年后制造出了一种叫做“晶体管”的半导体器件。不甘被超越的肖克利则在一年后开发出了一种更新的晶体管。又过了十年,他们三人因为在晶体管领域的贡献,获得了诺贝尔物理学奖。而随着晶体管领域的不断扩大,迎来更多的新成员,它们也成为了数字时代的基石。

芯片和硅谷的诞生

随着晶体管逐渐替代真空管,它们的局限也在实际应用中暴露了出来。其中最主要的一个问题是如何在成千上万个晶体管中布线,组成可用的电路。

为了让晶体管实现复杂的功能,电路中除了晶体管外,还需要电阻、电容、电感等元件,再进行焊接和电路连接。这些元件本身尺寸就没有一个标准,制作电路的工作量巨大,而且极易出错。当时的一个解决思路是规定每个电子元件的大小和形状,用模块化的手段重新定义电路的设计。

德州仪器公司的杰克·基尔比(JackKilby)对这个计划并不感冒,认为它解决不了根本上的问题——再怎么规定,尺寸也小不了。最终造出来的模块化电路依旧庞大,无法应用到体积较小的设备中。他的方案将一切都进行集成,把所有的晶体管、电阻以及电容都放在一块半导体材料上,省去了大量的后续制造时间,也减少了犯错的可能。

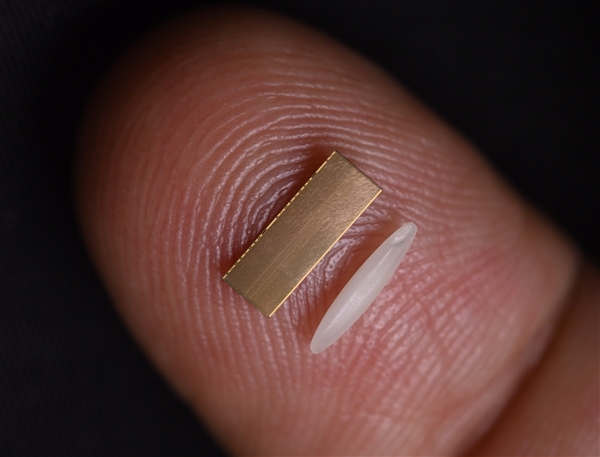

1958年,他用“锗”(Ge)做出了一个原型,里头包含一个晶体管、三个电阻以及一个电容,在用导线连接后,能产生正弦波。这种崭新的电路被称为“集成电路”,后来也有了个大家更为熟知的简称——芯片。基尔比本人在2000年斩获诺贝尔物理学奖,表彰他的发明。

差不多同一个时期,八名工程师同时向肖克利提出辞职,继而一起创业,建立了仙童公司(FairchildSemiconductor)。这八个辞职者,就是半导体历史上大名鼎鼎的“八叛逆”。罗伯特·诺伊斯(RobertNoyce)是这八名叛逆者中的领袖,也想到在一块半导体材料上生产多个元件,制造集成电路。

与基尔比的方法不同,他的设计将导线与各个元件都整合到一块。这种一体化的设计在生产制造上有着更大的优势,唯一的问题是成本——诺伊斯的集成电路虽然优势明显,成本却是原来的50倍。

正如几十年前的战火催生出了计算机的雏形,冷战也为诺伊斯的芯片带来了意外的商机。随着前苏联发射第一颗人造卫星,并首次将人类送上太空,感受到危机的美国启动了全面追赶计划。他们决定把人送上月球作为最终反击,然而这一工作需要巨大的计算量(控制火箭、操纵登陆仓、计算最佳时间窗口等),美国太空总署(NASA)则把命运赌在了诺伊斯的芯片上:这种集成电路体积更小,耗电量也更低。为了把人送上月球,每一克重量,每一瓦能源都要斤斤计较。对于这种极限项目,它无疑是更好的选择。

在人类登月项目上,芯片向全世界展示了自己的潜力——诺伊斯说在阿波罗项目的电脑里,它的芯片运行了1900万个小时,只出现了2次故障,其中1次还是外部因素造成的。

此外,登月行动也证实芯片能在外太空这个极端恶劣的环境下正常运作。仙童崛起后,来自这家公司的员工也在当地开枝散叶,建立了英特尔、AMD等公司,这块半导体公司密布的地区,后来也有了一个更响亮的名字——硅谷。

光刻技术

集成电路的尺寸比由零散的晶体管元件组成的电路要小许多,往往需要用到显微镜才能看清里头的结构,检查质量。德州仪器公司的杰伊·拉斯洛普(JayLathrop)在一次观察中突发奇想,显微镜从上往下看可以把东西放大,那么从下往上看,是不是就能把东西给变小呢?

这可不是为了好玩。当时集成电路的尺寸已经接近手工制造的极限,很难再取得新的突破。而如果能把设计好的电路图“缩印”到半导体材料上,就有可能通过自动化的技术进行制造,实现量产。

拉斯洛普很快就检验了他的想法。首先他从柯达公司买到了一种叫做光阻剂的化学物质,将它涂在半导体材料上。然后他按设想把显微镜颠倒了过来,并在镜头上盖上了一块板,只留下一个小图案。

最后,他让光线穿过镜头,照到了显微镜另一端的光阻剂上。在光线的作用下,光阻剂发生化学反应,慢慢溶解消失,露出了下方的硅材料。而露出的材料形状,和他最初设计的图案如出一辙,只是缩小了成百上千倍。在暴露出的凹槽上,制造人员可以添加新的材料,连接起电路,再洗去多余的光阻剂。这一套流程就是制造芯片的光刻技术。

德州仪器公司随后进一步完善了这套流程,使每个环节都能有标准进行参考,这也让集成电路迎来了标准化的量产时代。而随着芯片变得越来越复杂,制作一块集成电路,至少需要重复这个过程几十次。

仙童也紧随其后,开发起了自己的光刻生产技术。诺伊斯之外,建立这家公司的其他七名创始人同样并非等闲之辈。其中高登·摩尔(GordonMoore)更是其中的佼佼者。

1965年,他对集成电路的未来进行了预测,认为随着光刻等生产技术不断更新,芯片中的元件数量每年都会翻倍。长远来看,芯片的算力将指数级增长,成本也会明显下降。这带来的一个显而易见的后果,就是芯片会大量走入寻常百姓家,彻底改变这个世界。摩尔的这个预测后来被叫做“摩尔定律”,为全世界所知。

摩尔定律成立的前提,是制造工艺的不断发展革新。早期一些公司开发的光刻技术近乎完美,简直就像把光线一笔一笔勾勒在光阻剂,刻出只有一微米宽度的线路。而且这种技术还可以一次性刻出多个芯片,大大提升了芯片的产能。然而在不断提升的芯片制造精度需求下,微米级的光刻机已经难以满足产业的需求,纳米级的光刻机成为了新的宠儿。

但研发这种光刻机并不容易——如何在越来越小的迷你空间里进行光刻,成了阻碍光刻技术发展的瓶颈。

极紫外光光刻技术

1992年,摩尔定律眼看就要失效——如果想要维持这一定律,芯片电路需要做得更加小巧。无论是使用的光源,还是光照过的镜头,都有着全新的要求。

拉斯洛普最初开发光刻技术之时,使用的是最为简单不过的可见光。这些光的波长在几百纳米左右,最终在芯片上印出的极限尺寸也是几百纳米。而如果需要在芯片上印出尺寸更小的元件(比如只有几十纳米),那需要的光源也要超越可见光的极限,迈入紫外光的领域。

一些公司开发过使用深紫外光(DUV)的制造设备,使用的波长不到200纳米。但从长远看,极紫外光(EUV)才是人们想到达的领域——波长越短,能刻在芯片上的细节就越多。最终,人们的目标定在了波长为13.5纳米的极紫外光上,而荷兰的ASML成为了世界上唯一的EUV机器生产商。

EUV技术开发了足足将近20年。为了制造可以运行的EUV机器,ASML需要在全球寻找最先进的零件来满足它的需求。作为光刻机,首先需要的就是光源:为了产生EUV,人们需要发射一个直径仅有几十微米的锡滴,让它以时速300多公里的速度穿越真空,同时用激光精准地打到它——不是一次,而是两次。

第一次是进行加热,第二次是用50万度的高温把它轰成等离子体,这个温度是太阳表面温度的好几倍。这样的过程,每秒要重复5万次,才能产生足够多的EUV。可以想象,这样的高精尖技术,需要多少先进的元件。

实际操作比上述的描述更为复杂。比如为了消除激光照射过程中产生的大量热量,需要用风扇进行通风,旋转速度需要达到每秒1000次。这一速度已经超过了物理轴承的极限,因此需要用磁铁把风扇悬停在空中进行旋转。

此外,激光发射器对其中的气体密度有着严格要求,还要避免激光照在锡滴上后产生反光,影响仪器。光是开发发射激光的机器,就耗费了10多年的研发时间,每台发射器需要超过45万个元件。

轰击锡滴后产生的EUV来之不易,研究人员还需要学会怎么收集这些光线,导向芯片。EUV的波长实在太短,很容易就被周围的材料吸收,而不是反射出去。最终蔡司(CarlZeiss)公司开发出了一种极为光滑的镜子,可以反射EUV。

这面镜子的光滑程度超出想象——用官方话语来说,如果把这面镜子放大到整个德国这么大,镜子不规则的地方最大也只有0.1毫米。该公司也信心十足地相信,他们的镜子可以导引激光,准确地击中位于月球上的高尔夫球。

这么一套繁复的设备,需要的不仅是科学技术,还需要供应链的完整管理。ASML本身只生产其EUV机器的15%的元件,其余来自全球各地的合作伙伴。当然,他们也会认真监控这些采购的产品,如有必要甚至会买下这些公司,自己亲力管理。这样一台机器,是不同国家的技术结晶。

第一台EUV机的原型在2006年诞生。2010年,第一台商用EUV机发货。而在未来几年,ASML预计将推出新一代的EUV机,每台造价3亿美元。

芯片的应用

在先进的制造工艺下,多种芯片诞生了。有人总结在21世纪,芯片可以分为三大类别。

第一种是逻辑芯片,用作我们电脑、手机,或者是网络服务器中的处理器;

第二类是记忆芯片,经典例子包括英特尔(Intel)公司开发的DRAM芯片——在这款产品推出前,资料的储存依赖于磁芯:磁化的元件代表1,未磁化的元件代表0。而英特尔的做法是把晶体管和电容器组合起来,充电代表1,不充电代表0。和磁芯相比,新的储存工具原理接近,但一切都整合在芯片中,所以体积更小,出错率也更低。此类芯片能为电脑提供运行时的短期和长期记忆;

第三类芯片则被叫做“模拟芯片”,处理模拟信号。

在这些芯片中,逻辑芯片可能更为人所熟知。尽管英特尔公司开发出了最早的DRAM记忆芯片,但它却在和日本公司的竞争中节节败退。1980年,英特尔与IBM达成一项合作,为个人电脑制造中央处理器,即CPU。

随着IBM第一台个人电脑的问世,搭建在这台电脑中的英特尔的处理器成为了产业的“标配”,就好像微软的Windows系统成了大众更为熟悉的操作系统一样。这场豪赌也让英特尔从DRAM领域彻底抽身,重新崛起。

CPU的开发并不是一蹴而就。其实早在1971年,英特尔就造出了第一个微处理器(和CPU相比,只能处理单个特定的任务),整套设计流程的开发用了足足半年。当时这个微处理器只有上千个元件,使用的设计工具只有彩色铅笔和直尺,落后得像是中世纪的工匠。琳·康维(LynnConway)开发了一种程序,解决了芯片的自动化设计问题。利用这种程序,从来没设计过芯片的学生,都可以在短短时间里学会怎么设计具有功能的芯片。

上世纪八十年代末,英特尔开发出了486处理器,能在一块微小的硅芯片上放上120万个微型元件,生成各种0和1。到了2010年,最先进的微处理器芯片已经能承载10亿个晶体管。这种芯片的开发,离不开少数几家寡头公司开发的设计软件。

另一种逻辑芯片——图形处理器(GPU,俗称显卡)在近年也愈发受人关注。在这一领域,英伟达(Nvidia)是重要玩家。在建立初期,该公司就相信3D图像是未来的发展方向,因此设计了能处理3D图形的GPU,并开发了一套相应的软件,告诉芯片应该如何工作。和英特尔的中央处理器“依次计算”的模式不同,GPU的优势在于能同时进行大量的简单运算。

谁也没有想到,在人工智能时代,GPU有了全新的使命。为了训练人工智能模型,科学家们需要用数据不断优化算法,让模型经过训练完成人类布置的任务,比如辨识猫狗,下围棋,或者和人类对话。此时,为了同一时间进行多次运算“并行处理”数据而开发出来的GPU有着得天独厚的优势,它也在人工智能时代焕发出了全新的生命。

而芯片的另一个重要应用是通信。厄文·雅各布(IrwinJacobs)看到芯片能处理一些复杂的算法,来编码海量信息,就和朋友们创立了高通公司(Qualcomm),进军通信领域。我们知道最早的移动电话又叫大哥大,像一块黑色的砖头。

随后,通信技术得到了飞速发展——2G技术可以传输图文,3G技术可以打开网站,4G足以流畅观看视频,而5G则能提供更大的飞跃。这里的每一个G,代表的都是“代”。可以看到,每一代无线技术,都让我们通过无线电波传递的信息呈指数上升。如今我们手机上看视频,稍稍有些卡顿就感到不耐烦。殊不知10多年前,我们还只能传文字短信。

高通参与了之后2G到后面其他手机技术的开发。利用依照摩尔定律不断进化的芯片,高通能通过无限的频谱,将更多的手机通话放到无垠的空间中。而为了升级5G网络,不仅需要在手机里放入新的芯片,也需要在基站中安装新的硬件。这些硬件和芯片凭借更强大的算力,能用无线的方法更快地传输资料。

生产制造以及供应链

1976年,几乎每家设计芯片的公司都有自己的制造基地。然而如果将芯片设计和芯片制造的工作分离开来,将制造芯片的工作交给专门的代工厂,可以大幅减少芯片设计公司的成本。

台积电应运而生,并承诺只制造芯片,不设计芯片。这样一来,设计芯片的公司不必担心机密资料外泄。而台积电也不依赖贩卖更多芯片——只要客户成功,他的公司就取得了成功。

在台积电之前,就有一些美国芯片公司将目光望向了浩瀚的太平洋对岸:上世纪六十年代,仙童就在香港建立了中心,组装从加州运来的各种芯片。投产的第一年,香港工厂就组装了1.2亿个装置,人力成本极低,但品质极好。十年内,美国几乎所有的芯片公司都在亚洲设立了组装厂。这也为芯片如今以东亚和东南亚为中心的供应链格局奠定了基础。

亚洲的高效和对质量的偏执,很快就对美国在芯片业上的地位带来了冲击。上世纪八十年代,负责检测芯片质量的公司高管们意外发现,日本生产的芯片质量已经超过了美国——普通的美国芯片故障率是日本芯片的4.5倍,品质最差的美国芯片故障率是日本芯片的10倍!“日本制造”不再是廉价但质量低劣的代名词。更可怕的是,即便是被压榨到极限的美国生产线,效率也远不及日本。“日本的资金成本只有6%到7%,我最好的时候,成本也要18%。”AMD的首席执行官杰瑞·桑德斯(JerrySanders)有一次说道。

金融环境也起到了推波助澜的效果:美国当时为了遏制通胀,利率一度高到21.5%;而日本的芯片公司都有财团在背后扶持,民众又习惯储蓄,使得银行能为芯片公司长期提供大额低息贷款。资本助力下,日本公司可以激进地抢夺市场。

此消彼长之下,最终有能力生产高级逻辑芯片的公司集中于东亚地区,制造出的芯片也随即送至周边进行组装。比如苹果公司的芯片主要在韩国和我国台湾地区生产,然后送到富士康进行组装。这些芯片不仅包括主处理器,也包括无线网和蓝牙的芯片,拍照用的芯片,感知动作的芯片等。

随着生产制造芯片的能力逐渐集中于少数公司,这些原本的代工公司也有了更大的权力,比如协调不同公司的需求,甚至制定规则。由于当下负责设计芯片的公司没有制造芯片的能力,只能听从建议。这些日益庞大的权力,也正是当下地缘政治角斗的话题之一。

结语

从解密二战密码的机器,到送人上月球的飞船。从随身播放音乐的随身听,到日常出行的飞机和汽车,再到我们阅读这篇文字时所用的手机和电脑,这些设备都离不开芯片。

每天,每个普通人的生活都会至少用到几十上百种芯片。这一切的一切,都离不开芯片技术的发展,以及对芯片的生产制造。芯片是这个时代最重要的发明之一,想要开发出新的芯片,不仅需要科学技术的加持,更需要先进的制造生产能力,以及应用这些芯片的民用市场。

芯片设计与制造能力的布局,经过了几十年的变迁,形成了当下的格局,也在当下这个时代产生了别样的意义。本文期待通过回溯过去几十年里关于芯片的一些重要产业节点,供感兴趣的读者们参考。

|